Big data eller small data

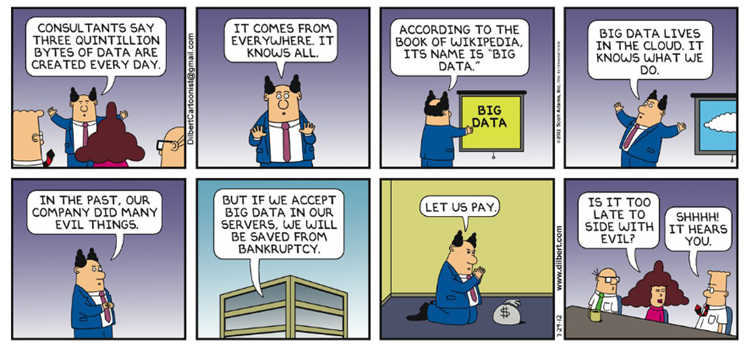

Begrebet ”Big data” bliver i dag ofte brugt i mange forskellige sammenhænge, til at dække over flere forskellige ting. Af samme årsag kan det ofte fremstå meget diffust hvad der menes med ”Big data”

En af de mest udbredte definitioner er baseret på ”de fem V’er”[1]: Velocity, Volume, Variety, Value and Veracity.

Velocity, volume og variety indkapsler kort fortalt konceptet om at man skal kunne analysere store datamængder, af mange forskellige typer, og gøre det hurtigt, så man er i stand til at drage nytte af analysen.

Værdien af data skabes når den kan sættes ind i en konkret kontekst. Hvis data kvaliteten derfor ikke er i orden, eller ikke kan organiseres, så at man kan inddrage den, bliver den ligegyldig underordnet hvor store mængder du har til rådighed.

En stor volume af data er i sig selv uinteressant, da en større datamængde ikke nødvendigvis vil give en større indsigt. Store datamængder har sin force hvor data er tvetydig, og mindre datamængder ikke er i stand til at give entydige konklusioner. Her kan store datamængder hjælpe med at øge nøjagtigheden af analysen og på den måde skabe ny indsigt.

Det kan være en stor opgave at organisere data, hvilket skal tages med i overvejelserne når man vil arbejde på store komplekse mængder af data. Hvordan data skal organiseres, afhænger i høj grad af konteksten hvorved den skal bruges og man skal derfor have en klar ide om hvilke analyser man ønsker at lave og de dertilhørende forretningsprocesser.

Det er med dataanalyser som det er med ens kost. Jo større variation af mad jo bedre vil systemet også fungere. Jo større variation af data der er til rådighed jo større er chancen for at der kan laves nye analyser eller forbedringer til eksisterende. Der bliver dannet rigtig meget data som tidligere ikke var til rådighed og der er derfor også et stort ubrugt potential heri. Indsamlingen samt kvalitetssikringen af disse data er dog ikke ligetil og uden problemer. Man bør derfor ej blot hive data’en ned fra hylderne som børn i en slikbutik, men forholde sig kritisk over for hvad man vil have.

Eksempler på DBMS-platforme der prøver at tage hånd om de ovenfor nævnte problemer er Snowflake og Amazon Web Services(AWS) der tilbyder datawarehouse-as-a-service(DaaS). Dette skifte fra et traditionelt data warehouse til DaaS gør at brugerne får nogle væsentligt simplere processer således at tiden kan blive lagt på at skabe værdi af produktet frem for administrative opgaver.

Af de 5 V’er er det værdien som bør være den primære faktor. Det er ved at forstå forretningsprocesserne og hvordan den foreslåede løsning vil give forretningsmæssig værdi, at en løsning bør designes. Der findes ikke en ”One-size fits all” løsning, men vil altid afhænge af den konkrete opgave der stilles og dens betingelser. Parametrene volume, variety, veracity og velocity bør derfor primært ses som parametre der kan benyttes alt efter opgaven og den kontekst hvorved opgaven er stillet.

Hvilke forretningsprocesser kunne de ønske at få skabt indsigt i? Skriv i kommentarfeltet og jeg skal vende tilbage med et svar.

[1] https://www.ibm.com/blogs/watson-health/the-5-vs-of-big-data/