Sociala robotar – var går gränsen till vad man får göra?

De sociala robotarna gör nu sitt inträde i vårt samhälle. De är psykologer i USA, barnvakter i Kina och här i Sverige arbetar ett antal spännande start-ups med dem. Men det här kommer innebära helt nya risker och etiska överväganden. Var går egentligen gränsen till vad vi får göra och hur ska vi försäkra oss om att vår framtid inte blir som en science fiction-dystopi?

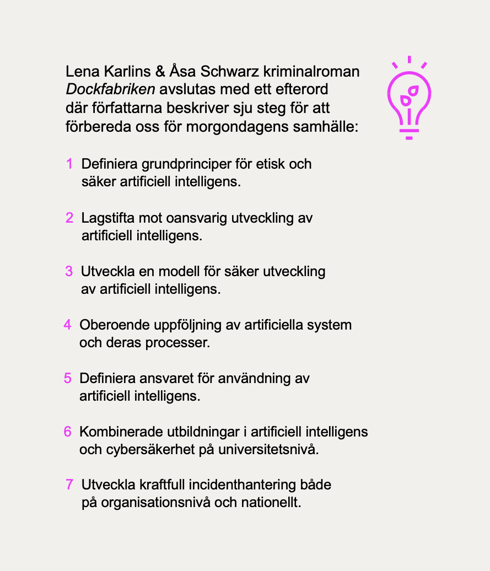

– Det finns många anledningar till att utveckla sociala robotar, menar Lena Karlin, som är aktuell med AI-deckaren Dockfabriken. Ett exempel är de robotpsykologer som finns idag. Jag tror att människor kan öppna upp på ett annat sätt än de skulle våga göra inför andra människor. Det kan röra sig om hemska krigsminnen eller kanske pinsamma vardagssaker.

– Vi ser också att vissa barn med speciella behov lär sig mer när de undervisas av robotar än i klassrumssituationen, säger Åsa Schwarz, författare och säkerhetskonsult. Ur ett rent personligt perspektiv så är det första jag tänker på allt hushållsarbete jag har där hemma som jag gärna överlåter till någon som inte protesterar.

Men allt är inte bara guld och gröna skogar. Eftersom tekniken är så kraftfull så ökar även riskerna om den inte hanteras på rätt sätt.

– Det finns idag något som kallas Duplex, berättar Daniel Akenine, teknik- och säkerhetschef på Microsoft, som gör att en robotröst kan ringa till människor utan att de hör att det är en maskin. Men är det verkligen bra?

– Det finns ingen lagstiftning på området, men rent etiskt tycker jag inte att det är okej, eftersom som man skulle känna sig lurad om man i efterhand fick veta att det var en AI som ringt. I framtiden, när detta är en del av vår vardag, så kanske vi inte alls tycker att det är ett problem, säger Lena Karlin.

Generellt är människor mer rädda för robotar för att de sett många science fiction-filmer, medan ett större problem kan vara en intelligens som kan förflytta sig genom internet och sabotera vår infrastruktur, eller egentligen vad som helst som är uppkopplat mot nätet. Kanske även ta över vilken fysisk enhet som helst.

En annan ofta förekommande diskussion är den om singularitet, tidpunkten då en AI blir så intelligent att den kan börja utveckla sig själv. När människan väl är ute ur loopen kan utvecklingen gå blixtsnabbt. Om och när detta kan ske är forskarna helt oeniga.

– Det finns en risk att singulariteten uppstår, säger Daniel Akenine, men man överdriver ofta tidsaspekten när det gäller sådana saker. Ett exempel är den självkörande bilen. För fem år sedan trodde alla att vi skulle köra runt i självkörande bilar, men så är det ju inte. Däremot så kommer allt som är tekniskt möjligt att hända, frågan är bara när. Kan singulariteten inträffa så kommer den att inträffa.

– Det kanske inte heller är detta som är den stora risken i närtid, menar Åsa Schwarz, utan snarare ett system som löser uppgiften det fått men på ett annat sätt än människor förväntar sig. Som till exempel städroboten som kommer på vilka det är som skräpar ned och stoppar dem istället för att städa.

Det finns idag ingen lagstiftning när det gäller trygg utveckling av AI-system och det kanske kommer att dröja. Men det finns inget som hindrar dem som arbetar med det idag att börja arbeta aktivt med riskerna.

– Den största riskfaktorn är ändå människan, säger Lena Karlin, och vad de gör med tekniken. Vi har ju inte förvaltat det så bra hittills.

Bloggposten bygger på ett seminarium där Åsa Schwarz, Lena Karlin och Daniel Akenine diskuterar frågorna.

Daniel Akenine arbetar som teknik- och säkerhetschef förMicrosoft, men är också initiativtagare till bland annat boken AI och människor och författare till 11 gram sanning.

Lena Karlin har tidigare skrivit tre barnböcker och varit styrelseledamot i Författarförbundets översättarsektion. Hon har översatt ett hundratal böcker, bland annat Dan Brown och Ken Follett.

Åsa Schwarz har ett flertal skönlitterära verk bakom sig. Hon jobbar även på Knowit och blev 2017 utsedd till Sveriges säkerhetsprofil. Hon förekommer ofta som expert i media inom säkerhet och artificiell intelligens.